Retrieval Augmented Generation(RAG)からRAPTOR(木構造化検索のための再帰的抽象処理)への旅は、幻覚や自信を持って間違った応答といった課題に対処する上での重要な進展を示しています。

Ollamaとオープンソースツールによって支えられたこの開発経路は、AIの精度と使いやすさを向上させます。

RAG(Retrieval Augmented Generation)を理解する

RAGは、事前に訓練されたモデルをJSON、PDF、またはGitHubリポジトリなどの外部ソースからのユーザー特有のデータで補完することにより、AIの応答を改善します。このデータはベクトルストアに保存されるチャンクに変換され、AIが関連情報を取得できるようにし、幻覚や不正確な回答を減少させます。

RAGフュージョンへの進展

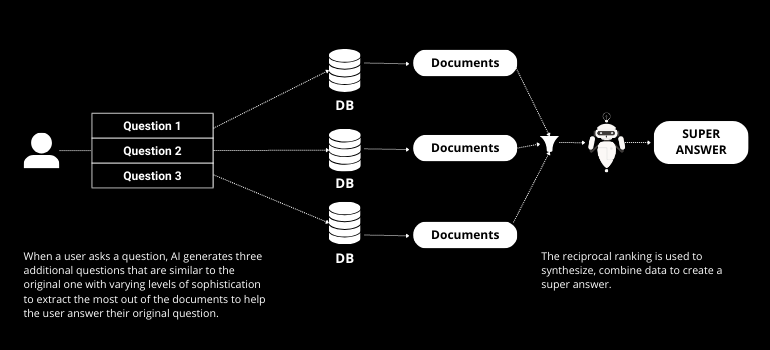

RAG Fusionは、マルチクエリ生成と逆ランキングを取り入れることでRAGを基盤としています。マルチクエリ生成は、AIがユーザーの元のクエリから複数の質問を作成し、検索プロセスを強化します。逆ランキングは、これらの回答をランク付けし、最も正確で関連性の高い応答が提供されることを保証します。

RAPTOR(ツリー組織化された検索のための再帰的要約処理)の紹介

RAPTORは、AI検索をさらに一歩進めます。従来のRAGとは異なり、RAPTORはデータをツリー構造で整理し、下から上に向かって各層で要約します。この方法は、より広い文脈を捉え、大規模な議論の表現を強化し、短いテキストチャンクのみを取得するという制限を克服します。

Ollamaとオープンソースツールを使用した実践的な実装

GitHubで利用可能なツールを使用して、RAPTORは簡単に実装できます。このプロセスには、データをJSONに変換し、埋め込みを作成し、ベクトルストアに保存されたツリー構造に整理することが含まれます。Ollamaは、これらのプロセスをローカルで実行するためのインフラを提供し、プライバシーとセキュリティを確保します。

ステップバイステップ:RAGからRAPTORへ

- データ準備データソースをJSONに変換し、LangChainにロードします。

- テキスト分割再帰的または意味的なチャンク分割を使用して、テキストを管理しやすい部分に分けます。

- 埋め込みの作成プライバシーを確保するために、ローカルモデルを使用して埋め込みを生成します。

- ツリー組織各層でデータを要約することによってツリー構造を構築します。

- ストレージと取得効率的な取得のために、ベクトルストアにツリーを保存します。

RAPTORの利点

RAPTORのツリー組織化されたアプローチは、いくつかの利点を提供します:

- 強化されたコンテキスト: より大きなディスコース構造を捉え、応答の精度を向上させます。

- 効率的な情報検索: ツリー構造により、より迅速で関連性の高い情報検索が可能になります。

- スケーラビリティ: 複雑な構造を持つ大規模データセットを扱うのに適しています。

結論

RAGからRAPTORへの進化は、AIの情報検索能力における重要な飛躍を示しています。この進展は、AIの応答における主要な課題に対処し、開発者や研究者にとって価値あるツールとなります。

このエキサイティングな時代を切り抜けるために、情報を得て関与し続けることが重要です。私たちのプラットフォームと共に、 NextBrain AI言語モデルの全力を活用して、データを簡単に分析し、戦略的な洞察を得ることができます。 今日デモのスケジュールを設定してください AIがあなたのデータから何を明らかにできるかを見てみましょう。

+34 910 054 348

+34 910 054 348 +44 (0) 7903 493 317

+44 (0) 7903 493 317