El viaje desde la Generación Aumentada por Recuperación (RAG) hasta RAPTOR (Procesamiento Abstractivo Recursivo para Recuperación Organizada en Árbol) marca un progreso significativo en la resolución de desafíos como las alucinaciones y las respuestas incorrectas con confianza.

Impulsado por Ollama y herramientas de código abierto, este camino de desarrollo aumenta la precisión y usabilidad de la IA.

Comprendiendo RAG (Generación Aumentada por Recuperación)

RAG mejora las respuestas de la IA al complementar modelos preentrenados con datos específicos de los usuarios provenientes de fuentes externas como JSON, PDFs o repositorios de GitHub. Estos datos se transforman en fragmentos almacenados en un almacén vectorial, lo que permite a la IA recuperar información relevante, reduciendo las alucinaciones y las respuestas incorrectas.

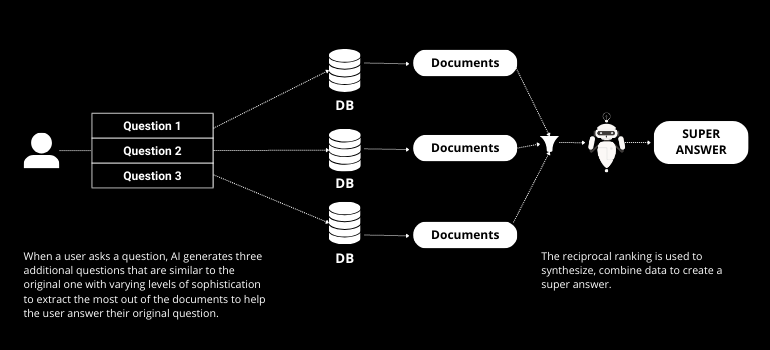

Avanzando hacia la fusión RAG

RAG Fusion se basa en RAG al incorporar la generación de múltiples consultas y el ranking recíproco. La generación de múltiples consultas implica que la IA crea varias preguntas a partir de la consulta original del usuario, mejorando el proceso de recuperación. El ranking recíproco clasifica estas respuestas, asegurando que se proporcione la respuesta más precisa y relevante.

Presentamos RAPTOR (Procesamiento Abstractive Recursivo para Recuperación Organizada en Árbol)

RAPTOR lleva la recuperación de IA un paso más allá. A diferencia del RAG tradicional, RAPTOR organiza los datos en una estructura de árbol, resumiendo en cada capa de abajo hacia arriba. Este método captura un contexto más amplio y mejora la representación de discursos a gran escala, superando las limitaciones de recuperar solo fragmentos de texto cortos.

Implementación Práctica con Ollama y Herramientas de Código Abierto

Utilizando herramientas disponibles en GitHub, RAPTOR se puede implementar con facilidad. El proceso implica convertir datos en JSON, crear embeddings y organizarlos en una estructura de árbol almacenada en un almacén de vectores. Ollama proporciona la infraestructura para ejecutar estos procesos localmente, garantizando privacidad y seguridad.

Paso a Paso: De RAG a RAPTOR

- Preparación de DatosConvierte fuentes de datos en JSON y cárgalas en LangChain.

- División de textoUtiliza el fragmentado recursivo o semántico para dividir el texto en partes manejables.

- Creación de EmbeddingsGenera incrustaciones utilizando modelos locales para garantizar la privacidad.

- Organización de Árboles: Construir una estructura de árbol resumiendo datos en cada capa.

- Almacenamiento y RecuperaciónAlmacena el árbol en un almacén de vectores para una recuperación eficiente.

Beneficios de RAPTOR

El enfoque organizado en árboles de RAPTOR ofrece varios beneficios:

- Contexto Mejorado: Captura una estructura de discurso más grande, mejorando la precisión de la respuesta.

- Recuperación EficienteLa estructura de árbol permite una recuperación de información más rápida y relevante.

- EscalabilidadApropiado para manejar grandes conjuntos de datos con estructuras complejas.

Conclusión

La evolución de RAG a RAPTOR marca un salto significativo en las capacidades de recuperación de IA. Este progreso aborda desafíos clave en las respuestas de IA, convirtiéndolo en una herramienta valiosa para desarrolladores e investigadores.

Así que mantenerse informado y comprometido es crucial mientras navegamos esta emocionante era. Con nuestra plataforma, NextBrain IApuedes aprovechar todo el poder de los modelos de lenguaje para analizar tus datos sin esfuerzo y obtener conocimientos estratégicos. Programa tu demostración hoy. para ver lo que la IA puede revelar de tus datos.

+34 910 054 348

+34 910 054 348 +44 (0) 7903 493 317

+44 (0) 7903 493 317