Im Kern des maschinellen Lernens liegt ein fundamentales Konzept: Algorithmen. Diese Anweisungssets leiten Computer an, Aufgaben auszuführen, von einfachen Berechnungen bis hin zu komplexen Problemlösungsoperationen. Das Verständnis dieser Algorithmen kann entmutigend sein, aber keine Sorge. Dieser Artikel entmystifiziert einige der häufigsten Algorithmen des maschinellen Lernens und erklärt deren Wesen und Anwendungen.

Die Bausteine: Algorithmen verstehen

Ein Algorithmus ist im Wesentlichen ein Rezept zur Lösung eines Problems. Er besteht aus einer endlichen Reihe von Schritten, die in einer bestimmten Reihenfolge ausgeführt werden, um eine bestimmte Aufgabe zu erfüllen. Es ist jedoch wichtig zu beachten, dass ein Algorithmus kein vollständiges Programm oder Code ist; es ist die Logik, die einer Lösung für ein Problem zugrunde liegt.

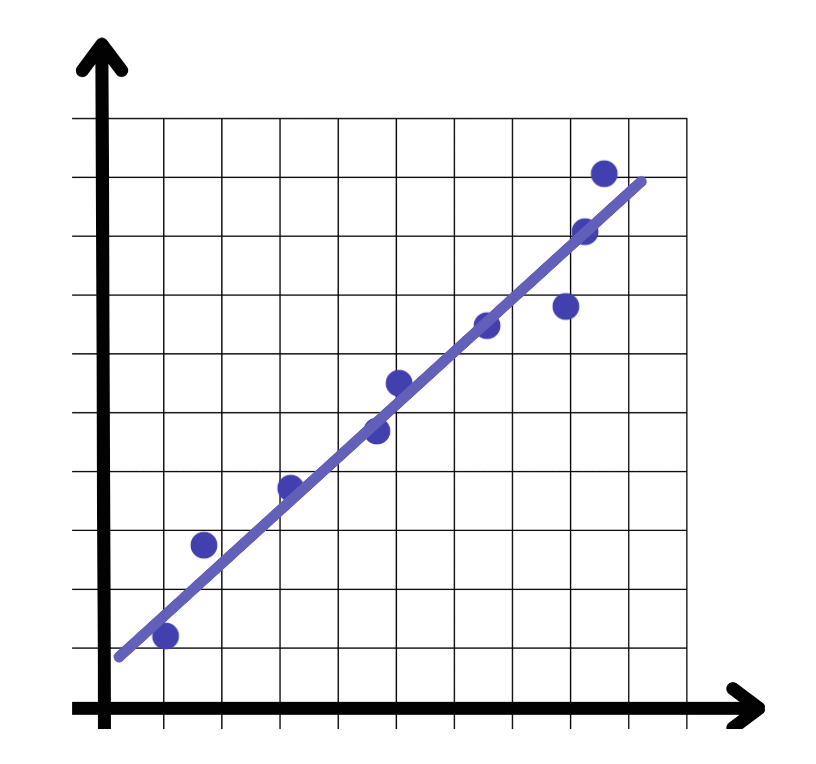

Lineare Regression

Die lineare Regression ist ein überwachter Lernalgorithmus, der als grundlegender Baustein im Machine Learning dient. Sie versucht, die Beziehung zwischen einer kontinuierlichen Zielvariablen und einem oder mehreren Prädiktoren zu modellieren. Durch das Anpassen einer linearen Gleichung an beobachtete Daten hilft die lineare Regression, Ergebnisse basierend auf neuen Eingaben vorherzusagen. Stellen Sie sich vor, Sie versuchen, die Preise von Häusern basierend auf ihrer Größe und Lage vorherzusagen; die lineare Regression ermöglicht dies, indem sie die lineare Beziehung zwischen diesen Variablen identifiziert.

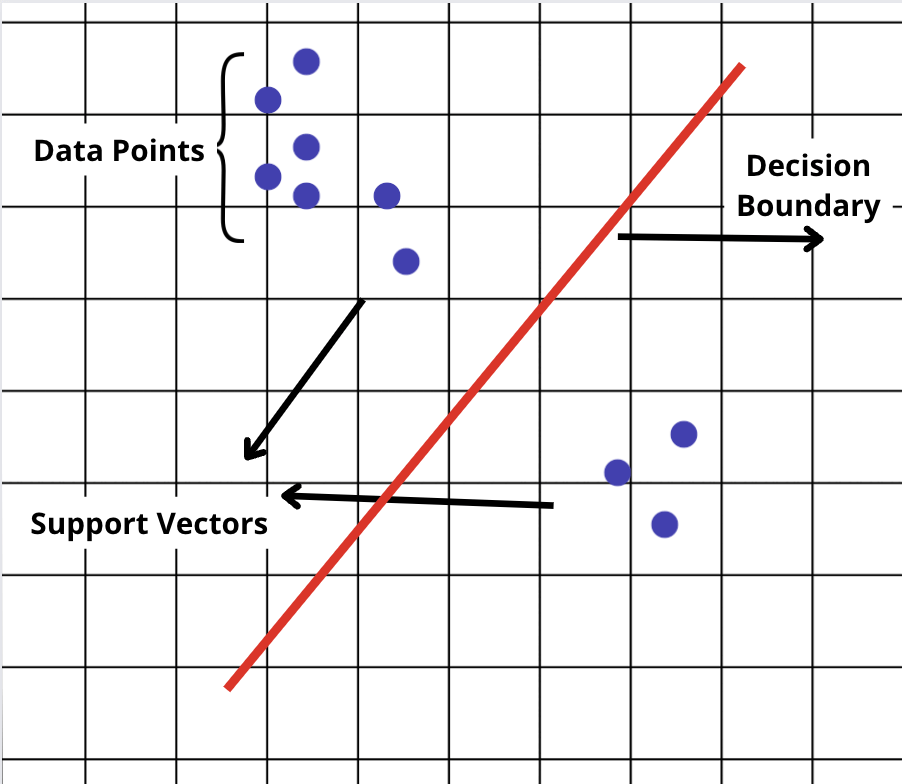

Support Vector Machines (SVM)

SVM ist ein weiterer überwachter Lernalgorithmus, der hauptsächlich für Klassifikationsaufgaben verwendet wird. Er unterscheidet zwischen Kategorien, indem er die optimale Grenze — die Entscheidungsgrenze — findet, die verschiedene Klassen mit so großem Abstand wie möglich trennt. Diese Fähigkeit macht SVM besonders nützlich in Situationen, in denen die Unterscheidung zwischen Klassen nicht sofort offensichtlich ist.

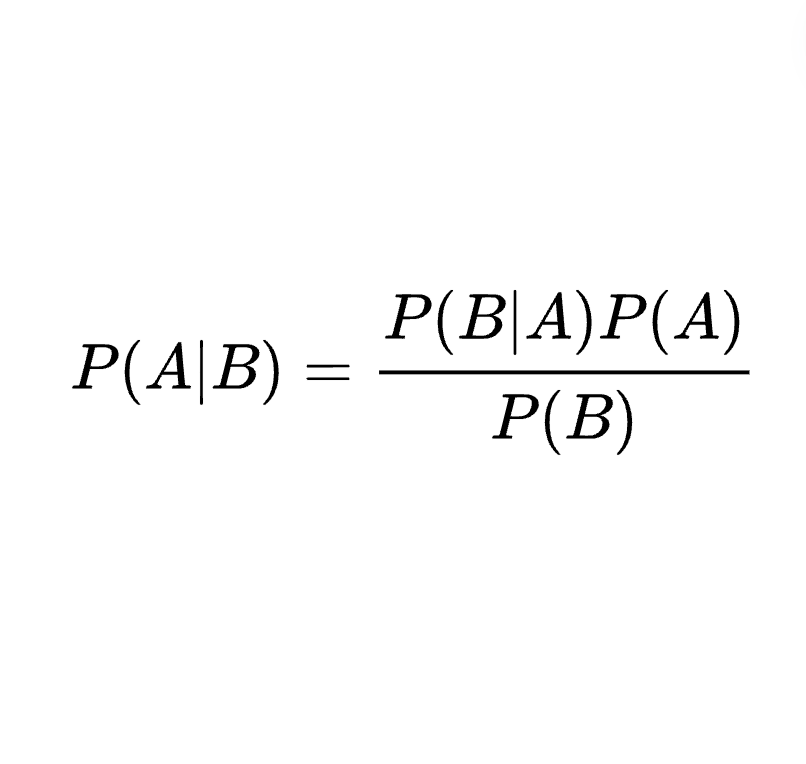

Naiver Bayes

Der Naive-Bayes-Klassifikator basiert auf einer einfachen Annahme: Die Merkmale, die er analysiert, sind unabhängig voneinander. Trotz dieser Einfachheit kann Naive Bayes äußerst effektiv sein, insbesondere bei Textklassifizierungsaufgaben wie der Spam-Erkennung. Er wendet den Bayes'schen Satz an und aktualisiert die Wahrscheinlichkeit einer Hypothese, wenn mehr Beweise verfügbar werden.

Logistische Regression

Die logistische Regression wird häufig für binäre Klassifikationsprobleme verwendet — Situationen, in denen es nur zwei mögliche Ergebnisse gibt. Durch die Anwendung der logistischen (oder sigmoiden) Funktion transformiert sie lineare Beziehungen in Wahrscheinlichkeiten und bietet ein leistungsstarkes Werkzeug für binäre Entscheidungen. Ob zur Vorhersage von Kundenabwanderung oder zur Identifizierung von Spam-E-Mails, die logistische Regression sorgt für Klarheit in einer binären Welt.

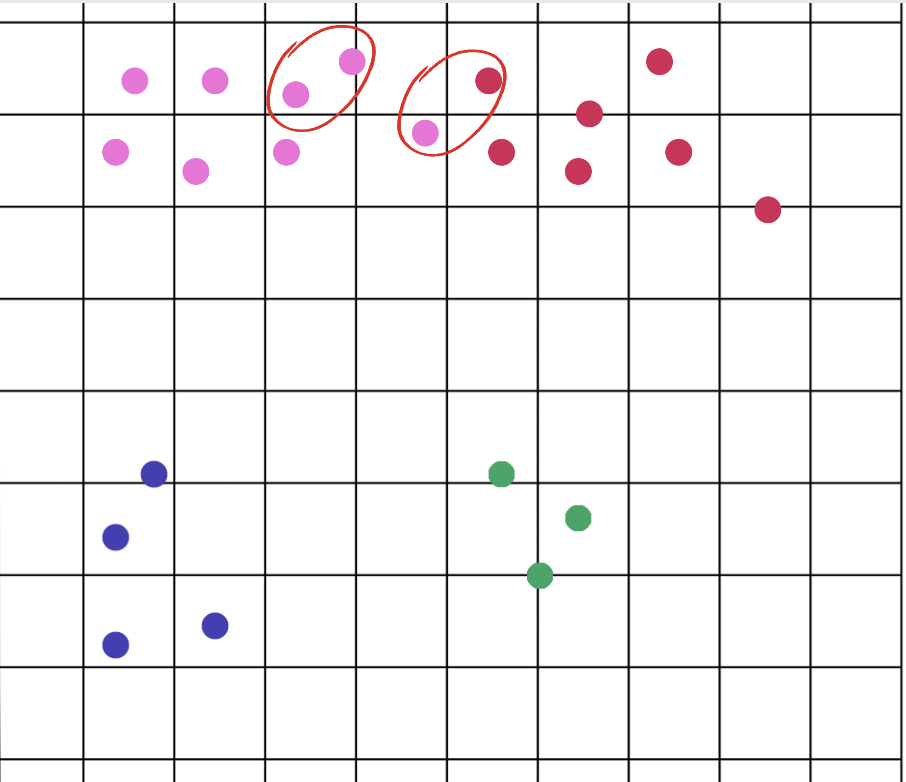

K-Nearest Neighbors (KNN)

KNN ist ein vielseitiger Algorithmus, der sowohl für Klassifikation als auch für Regression verwendet wird. Er sagt den Wert oder die Klasse eines Datenpunkts basierend auf der Mehrheit der Stimmen oder dem Durchschnitt seiner 'K' nächsten Nachbarn voraus. Die Schönheit von KNN liegt in seiner Einfachheit und Effektivität, insbesondere in Anwendungen, bei denen die Beziehung zwischen Datenpunkten ein signifikanter Prädiktor für ihre Klassifikation ist.

Entscheidungsbäume

Entscheidungsbäume teilen Daten in Äste auf, um eine Reihe von Entscheidungswegen darzustellen. Sie sind intuitiv und leicht zu interpretieren, was sie beliebt für Aufgaben macht, die Klarheit darüber erfordern, wie Entscheidungen getroffen werden. Während Entscheidungsbäume leistungsstark sind, sind sie anfällig für Overfitting, insbesondere bei komplexen Daten.

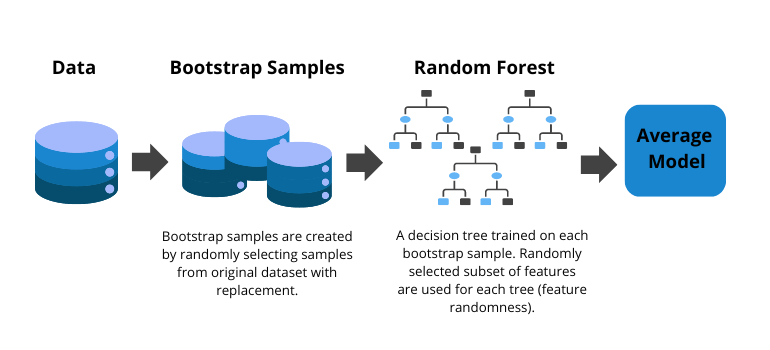

Random Forests

Random Forests verbessern Entscheidungsbäume, indem sie ein Ensemble von Bäumen erstellen und deren Vorhersagen aggregieren. Dieser Ansatz verringert das Risiko von Overfitting, was zu genaueren und robusteren Modellen führt. Random Forests sind vielseitig und anwendbar auf sowohl Klassifikations- als auch Regressionsaufgaben.

Gradient Boosted Decision Trees (GBDT)

GBDT ist eine Ensemble-Technik, die die Leistung von Entscheidungsbäumen verbessert. Durch das sequentielle Korrigieren von Fehlern vorheriger Bäume kombiniert GBDT schwache Lernende zu einem starken prädiktiven Modell. Diese Methode ist äußerst effektiv und bietet Präzision sowohl bei Klassifikations- als auch Regressionsaufgaben.

K-means-Clustering

K-means-Clustering gruppiert Datenpunkte basierend auf Ähnlichkeit, eine grundlegende Technik im unüberwachten Lernen. Durch die Partitionierung von Daten in K unterschiedliche Cluster hilft K-means, inhärente Gruppierungen innerhalb der Daten zu identifizieren, nützlich in der Marktsegmentierung, Anomalieerkennung und mehr.

Hauptkomponentenanalyse (PCA)

PCA ist eine Technik zur Dimensionsreduktion, die eine große Anzahl von Variablen in eine kleinere umwandelt, die dennoch die meisten Informationen der großen Menge enthält. Durch die Identifizierung der Hauptkomponenten vereinfacht PCA die Komplexität und ermöglicht klarere Einblicke und effizientere Berechnungen.

Zusammenfassung

Machine Learning-Algorithmen sind die Motoren, die Fortschritte in der KI und Datenwissenschaft antreiben. Von der Vorhersage von Ergebnissen mit linearer Regression bis hin zum Gruppieren von Daten mit K-means-Clustering bieten diese Algorithmen ein Toolkit zur Lösung einer Vielzahl von Problemen. Das Verständnis der grundlegenden Prinzipien hinter diesen Algorithmen entmystifiziert nicht nur das Machine Learning, sondern öffnet auch eine Welt voller Möglichkeiten für Innovation und Entdeckung. Egal, ob Sie ein erfahrener Data Scientist oder ein neugieriger Enthusiast sind, die Reise in die Welt der Machine Learning-Algorithmen ist sowohl faszinierend als auch äußerst lohnend.

Um Ihre Arbeit mit KI zu vereinfachen, haben wir Next Brain AI, ausgestattet mit vorgefertigten Algorithmen, um mühelos Erkenntnisse aus Ihren Daten zu gewinnen. Vereinbaren Sie noch heute eine Demo um zu erleben, wie es Sie bei der strategischen Entscheidungsfindung unterstützen kann.

+34 910 054 348

+34 910 054 348 +44 (0) 7903 493 317

+44 (0) 7903 493 317